[2017/11/21 업데이트] AWS rekognition API가 크게 개선 되었습니다.

이제 해당 API를 통해 이미지 분석 뿐만 아니라 이미지에서 텍스트 문자를 추출하는 것이 가능해졌습니다.

AWS에 나와있는 업데이트 내용입니다:

Recognition은 거리 이름, 캡션, 제품 이름, 차량 번호판 등과 같은 이미지에서 텍스트 콘텐츠를 검색하고 인식합니다. 이미지의 텍스트는 문서 이미지 대신 실제 이미지로 작동하기 위해 특별히 제작되었습니다. 이미지를 분석할 때마다 인식된 텍스트와 각 검출된 단어 또는 라인에 대한 신뢰도 점수와 더불어 이미지의 텍스트가 인식된 텍스트와 함께 반환됩니다.

AWS Rekognition에서 실시간 이미지 인식, 얼굴 인식 기술이 개선되었습니다.

2017년 11월 21일 일요일

아마존 Rekognition은 오늘 세가지 새로운 기능을 추가했습니다. 이미지에 대한 인식과 인지도를 실시간으로 인식하고, 수많은 얼굴 표정에서 최대 100개의 얼굴을 감지합니다. 이미 검증 및 식별을 위해 Amazon Rekognition을 사용하고 있는 고객은 대부분의 경우 최대 10%의 정확도 향상을 경험할 것입니다.

이미지 안에 텍스트:

이미지의 물체와 얼굴에 있는 물체들을 인식하는 고객들은 우리에게 교통 카메라, 뉴스, 자막, 그리고 TV화면에 새겨진 문양과 같은 문구들을 인식하고 있습니다. 오늘부터 이미지에서 RecognitionText(인식 텍스트)를 사용하여 영상에서 텍스트 콘텐츠를 인식하고 추출할 수 있습니다. 이미지의 텍스트는 문서 이미지 대신 실제 이미지로 작동하기 위해 특별히 제작되었습니다. 대부분의 라틴어 스크립트와 다양한 레이아웃, 글꼴 및 스타일에 포함된 텍스트를 지원하며, 배너 및 포스터와 같은 다양한 방향으로 배경 개체에 중첩되어 있습니다.

예를 들어, 이미지 공유 및 소셜 미디어 응용 프로그램에서 이제 동일한 키워드를 포함하는 이미지 색인을 바탕으로 시각적 검색을 실행할 수 있습니다. 미디어 및 엔터테인먼트 응용 프로그램에서는 광고, 뉴스, 스포츠 점수 및 캡션과 같은 화면의 관련 텍스트를 바탕으로 비디오를 분류할 수 있습니다. 또한 보안 및 안전 응용 프로그램에서 거리 카메라가 찍힌 영상에서 차량 번호판 번호를 기준으로 차량을 식별할 수 있습니다.

Pinterest CTO, Vanja Josifovski

"시각적으로 주도적인 플랫폼으로서 Pinterest는 이미지의 속도와 품질에 크게 의존하지만, 이러한 이미지의 텍스트는 컨텍스트를 제공하고 200M+액티브 피너스를 실행할 수 있습니다. 이미지에서 Amazon Rekognition 이미지 내 텍스트를 사용할 때는 이미지에서 캡처한 풍부한 텍스트를 캡처하고 AmazonS3에 저장된 수백만개의 핀 만 낮은 지연 시간으로 줄일 수 있습니다. 당사는 Pinterest와 Pinterest에 있는 Pinners와 협력하기 위해 AWS와의 파트너십을 지속적하기를 기대하고 있습니다."

SmugMug, Don MacAskill

"전문 사진 작가들은 종종 스프라그 게임 비브의 숫자와 같은 사진을 포함한 사진을 공유하고 판매하기 위해 스무그 버그를 사용합니다. 이미지로 구성된 Amazon Rekognition 이미지 내 텍스트 인식은 규모에 맞게 비브 번호를 추출하고 이벤트 사진을 빠르고 쉽게 공유할 수 있는 이벤트 사진을 제공할 수 있습니다."

얼굴 검색 및 검색 : 아마존 서비스를 이용하면 수백만장의 얼굴을 가진 컬렉션에 대한 실시간 얼굴 수색을 수행할 수 있습니다. 이를 통해 검색 지연 시간은 5~10배 감소하며, 동시에 10-20배 더 많은 얼굴을 저장할 수 있는 컬렉션을 제공할 수 있습니다.

보안 및 안전 응용 프로그램에서, 당신은 실시간으로 수백만명의 사람들의 관심을 끌 수 있는 사람들을 식별할 수 있고, 적시에 정확한 범죄 예방과 같은 사용 사례를 이용할 수 있습니다. 워싱턴 주 보안관 사무실은 오리건 주의 시민들로부터 911신고를 받은 최초의 응답자입니다. 경찰청은 또 다른 도시 경찰 부서에 범죄 예방을 위한 지원을 제공하고 있습니다. 보안관 사무실은 이전에 2-3일 간의 용의자들의 신원 확인 시간을 줄이기 위해 이전에 Amazon Rekognition를 사용했었습니다.

워싱턴 주 보안관 사무실의 선임 정보 시스템 분석가, Chris Adzima

"이러한 개선을 통해 현장의 대표자들은 실시간으로 검색에 대한 응답을 받을 수 있습니다. 이를 통해 필요한 정보를 얻고 신속하게 조치를 취할 수 있습니다. 현장에서 몇 초는 생명 구조를 살리는 데 도움이 될 수 있습니다."

오늘부터 고객은 단일 이미지에서 최대 100개의 얼굴(15개)을 감지, 분석 및 색인화할 수 있습니다. 이러한 개선을 통해 그룹 사진, 혼잡한 사건, 공항 및 백화점과 같은 공공 장소의 모든 면에서 인구 통계를 정확하게 포착하고 감정을 분석할 수 있게 됩니다.

interaction model.txt

interaction model.txt

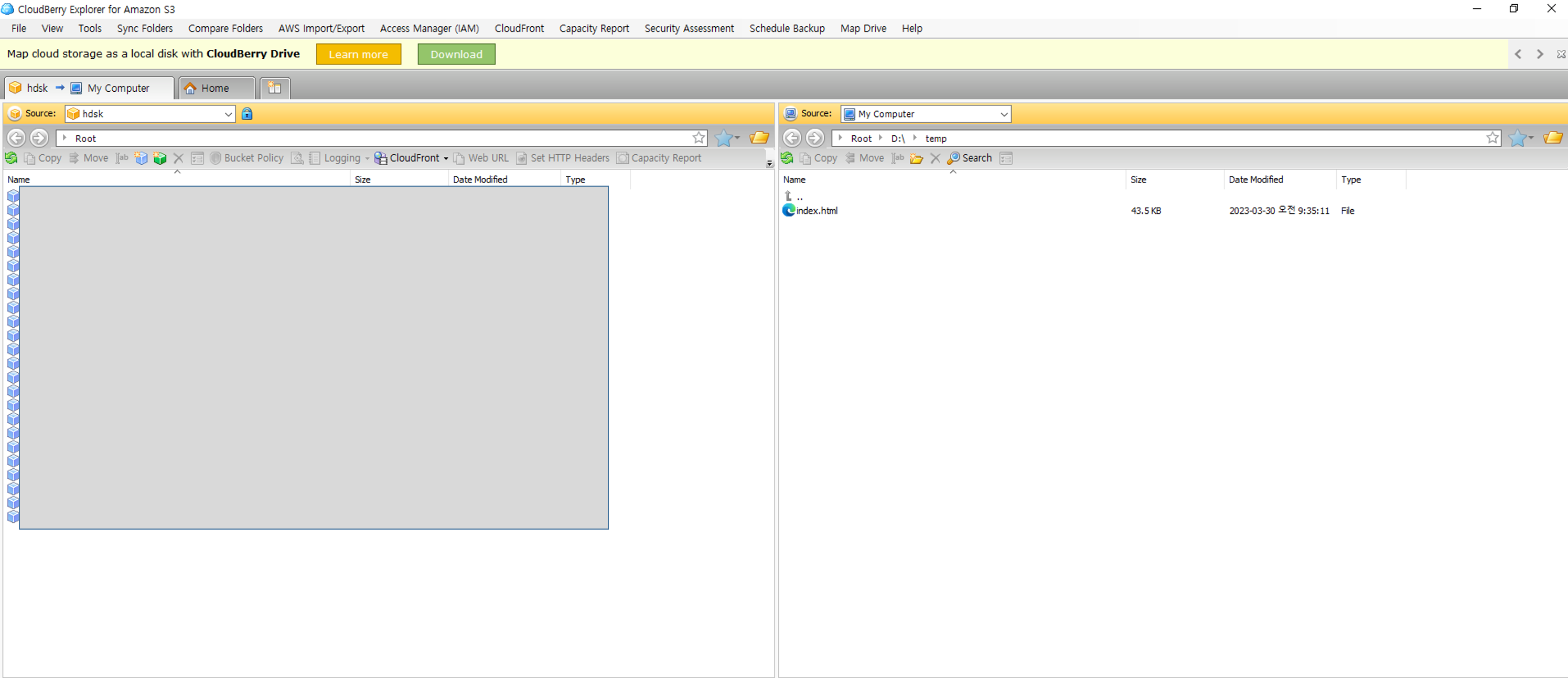

src_final.zip

src_final.zip